Por Aleks Farseev Miembro del Consejo de Tecnologia de Forbes del 17 de Febrero de 2023

Aleks Farseev Professor SoMin.ai (1)

Cuando explico las funciones de copia de anuncios y generación de banners de SoMin, a menudo me preguntan si reemplazamos GPT-3 con ChatGPT o si todavía estamos ejecutando modelos obsoletos. “No lo hemos hecho y no lo haremos”, suele ser mi respuesta, que a menudo siempre deja una gran sorpresa en la cara de nuestros clientes. A continuación, permítanme aclarar por qué doy esa respuesta a pesar de la creciente popularidad de la primera red neuronal de chatbot gigante de OpenAI, llamada ChatGPT.

Los asientos en la mesa

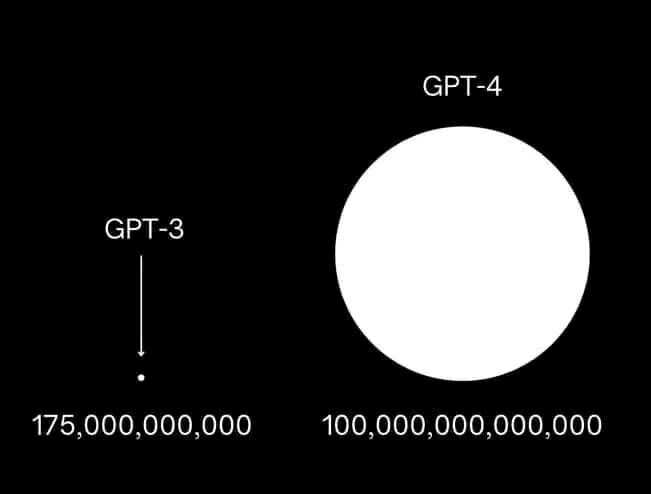

En primer lugar, GPT-2, GPT-3, ChatGPT y, muy probablemente, GPT-4 pertenecen a la misma familia de modelos de IA: transformadores. Esto significa que, a diferencia de la generación anterior de modelos de aprendizaje automático, están capacitados para resolver tareas más unificadas (también conocidas como metaaprendizaje), por lo que no requieren volver a capacitarse para cada tarea específica para producir resultados viables. Este último explica sus tamaños gigantes (175 mil millones de parámetros en el caso de GPT-3): un modelo necesita “recordar todo Internet” para ser lo suficientemente flexible como para “cambiar” entre diferentes piezas de datos que ha aprendido en función de la entrada del usuario. Luego, cuando un usuario especifica una consulta de entrada, describe la tarea y un par de ejemplos (tal como le explicaría a un bibliotecario qué tipo de libros le interesan), el modelo puede producir el resultado: voilà. Este enfoque se denomina “aprendizaje de pocos disparos”, que recientemente se ha convertido en una tendencia cuando se trata de dar entrada a los modelos de transformadores modernos.

Pero, ¿necesitamos siempre tener todo el conocimiento de Internet para resolver una tarea que tenemos entre manos? Ciertamente no, en muchos casos, al igual que con ChatGPT, requerimos un montón (bueno, unos pocos millones) de muestras de datos específicos de la tarea que permitirían que el modelo inicie el “Aprendizaje de refuerzo a partir de la retroalimentación humana (RLHF)”. procedimiento. RLHF, a su vez, derivaría de un proceso de capacitación colaborativo realizado entre la IA y los humanos para entrenar aún más el modelo para producir conversaciones atractivas como las de los humanos.

Como resultado, tenemos a ChatGPT sorprendiéndonos no solo por su excelente rendimiento en el escenario de Chatbot, sino también por ayudarnos a escribir contenidos breves, como poemas o letras de canciones, o contenido extenso, como documentos completos (Descargo de responsabilidad: este artículo está escrito 100 % por mí, un humano); explicar temas complejos en términos simples o conocimientos profundos cuando necesitamos una respuesta rápida; lluvia de ideas sobre nuevos temas e ideas, lo cual es útil en el proceso creativo; y apoyar a los departamentos de ventas en la comunicación personalizada, como la generación de respuestas por correo electrónico.

Deliberadamente, no he mencionado anteriormente aplicaciones como “Resumen de noticias diarias” o “Pronóstico del tiempo”: aunque técnicamente, los modelos de transformadores grandes podrían intentar resolver tales tareas, es poco probable que ChatGPT e incluso GPT-4 puedan hacerlo. —la razón es que ChatGPT y otros transformadores de OpenAI tienen un conocimiento muy limitado de los eventos mundiales porque son modelos preentrenados y, por lo tanto, sus actualizaciones de datos no se realizan con la frecuencia suficiente debido a los requisitos computacionales extremadamente pesados en el reentrenamiento del modelo. Esta es probablemente la mayor desventaja de todos los modelos preentrenados que OpenAI (y cualquier otro) ha producido hasta ahora. Un problema mayor es más específico de ChatGPT: a diferencia de GPT-3, se entrenó en un conjunto de datos conversacionales muy enfocado y, por lo tanto, solo en tareas conversacionales ChatGPT podrá superar a su hermano mayor, mientras que sería menos avanzado cuando se trata. a otras tareas de productividad humana.

Una familia en crecimiento

Muy bien, ahora entendemos que ChatGPT es solo una versión más pequeña y más específica de GPT-3, pero ¿significa que tendremos más modelos de este tipo en un futuro próximo: MarGPT para marketing, AdGPT para anuncios digitales, MedGPT para respuesta a preguntas medicas?

. ChatGPT no solo es más pequeño (20 000 millones frente a 175 000 millones de parámetros) y, por lo tanto, más rápido que GPT-3, sino que también es más preciso que GPT-3 a la hora de resolver tareas conversacionales: un caso comercial perfecto para un producto de IA de menor costo y mejor calidad. .

Entonces, ¿más grande es mejor cuando se trata de IA generativa?

La respuesta es que depende: cuando estamos construyendo un modelo de aprendizaje universal capaz de muchas tareas, entonces sí. Parece que cuanto más grande, mejor, y esto lo demuestra la superioridad de GPT-3 sobre GPT-2 y otros predecesores. Pero, cuando queremos hacer una tarea en particular realmente bien, como los chatbots en el caso de ChatGPT, entonces el enfoque de datos y el procedimiento de entrenamiento adecuado son de mucha mayor importancia en comparación con el modelo y el tamaño de los datos. Es por eso que en SoMin, no usamos ChatGPT para la generación de textos y pancartas, sino que aprovechamos los datos específicos relacionados con la publicidad digital para guiar a GPT-3 a producir mejor contenido para los nuevos anuncios que el mundo aún está por ver.

Entonces, ¿cuál es el futuro de la IA generativa?, uno se preguntaría.

Bueno, la multimodalidad es una de las progresiones inevitables que veremos en el próximo GPT-4, como lo mencionó el CEO de OpenAI, Sam Altman, en su discurso. Al mismo tiempo, Altman ha roto el rumor de que el modelo tiene 100 billones de parámetros. Todos sabemos que más grande no siempre es mejor.

Dr. Aleks Farseev is an Entrepreneur, Research Professor, Keynote Speaker and the CEO of SoMin.ai, a Long-Tail AI Ad Optimization Platform

Ver nota completa en https://www.forbes.com/sites/forbestechcouncil/2023/02/17/is-bigger-better-why-the-chatgpt-vs-gpt-3-vs-gpt-4-battle-is-just-a-family-chat/?sh=a8df925b6589